Cela fait un petit nomment , que je m’intéresse à la solution Home Assistant , je la testai sur mon réseau HUE et quelques autres capteurs , mais j’hésitais à transférer mon serveur Jeedom .

Je suis équipé de la solution HUE ( éclairage et capteur ) , de Sonos pour le multimedia , d’environ 80 capteurs et actionneurs Zwave ( fibaro , aeon , aeotec , nodon , qubino , etc … ) , j’utilise aussi le protocole RFX433 ( avec un RFXcom pour piloter mes volets Somfy ) et récupérer des infos de diverses sondes de température. j’utilise aussi des capteurs bluetooth ainsi que des appareils connectés en WI-FI.

Mais suite à des soucis de carte emmc défaillante , et de plus en plus de lenteur avec jeedom , je me suis posé la question de passer sur un NUC , comme la plupart des utilisateurs de domotique , mais pas vraiment envie d’investir encore de l’argent dans une nouvelle machine.Je me suis donc tourné vers mes ressources internes.

Je dispose de deux NAS synology ( dont un DS916+), pour différentes fonctions, comme serveur de photo, serveur de média et bien sûr mes sauvegardes . Et comme ils ne sont pas encore surexploités , je me suis mis en quête d’utiliser les ressources de mon NAS pour mon serveur domotique.

Au commencement …

Cela fait un petit nomment que je cherche, une solution viable dans le temps pour mon serveur domotique . J’ai commencé la domotique, en 2013, avec domoticz sur un raspberry, puis je suis passé sous jeedom qui m’offrait plus de fonctionnalité .Par la suite , mon raspberry a vite montré des problèmes de lenteur et de nombreuses cartes SD défaillantes .

Je suis passé sur un Odroid C2 avec une carte emmc, qui m’a permis de bien fonctionner sur ces quatre dernières années. Je lorgne du coté des NUC, pour améliorer la réactivité de ma domotique et gagner en confort, mais j’ai déjà beaucoup de ‘serveur » qui tourne à la maison, je cherche à centraliser et optimiser mes ressources . Je cherche une solution qui soit viable en production sur un NAS synology et plus particulièrement sous docker.

Ces derniers jours, mon serveur jeedom tombait régulièrement en panne … Le serveur Zwave tournait sans fin , il redémarrait une fois sur deux, les scénarios mettaient une dizaine de secondes à répondre … bref il fallait que je trouve une solution.

Sur mon NAS j’ai la possibilité d’utiliser soit Virtual Machine , soit la solution Docker. J’ai testé d’installer Jeedom sous virtual Machine, cela marche bien, mais ma nouvelle installation est toujours aussi lente, pas de bénéfice par rapport à mon odroid C2. De plus la VM, me prend beaucoup de ressources sur le NAS.

Installer jeedom sous docker, est réalisable, mais complexe à faire fonctionner et surtout à mettre à jour ( pas prévu pour ça), la remontée des clés USB Zwave et Rfxcom ne fonctionnait pas toujours très bien.

Lors de mes tests de home assistant , la réactivité est plus véloce , et la solution semble très bien adapté à DOCKER.

Pourquoi Home Assistant ?

- C’est une solution Open Source

- Possibilité de l’installer sur de nombreux environnements dont docker

- Sauvegarde très simple.

- Très grande communauté active.

- Rapide et conviviale.

- Mises à jours fréquentes

- Compatible avec synology

- Compatible avec les assistants vocaux

- Compatibilité homekit très simple / possibilité de simuler plusieurs « concentrateurs »

- De très nombreux plugins gratuit et mis à jour régulièrement

La force de home assistant est de pouvoir proposer gratuitement des plugins permettant de contrôler la quasi totalité ou presque de ce que l’on peut trouver dans le commerces comme objet connecté. La possibilité , d’afficher des informations dynamique en fonction d’état . La souplesse des scripts.

Il y a plein d’articles sur la solution , sur internet , je vous invites à lire tous ces articles avant de vous lancer.

Home assistant , existe aussi sous la forme HASS.IO , qui est un système complet qui peut être installé directement sur un raspberry ( il tourne sous Alpine linux ). La solution HASS.IO , est conseillé pour tous les utilisateurs , home assistant seul est plutôt destiné à un public plus averti.

Installation de Hass.IO sur SYNOLOGY .

Il y a plusieurs façons d’installer home assistant , mais le but de cet article et de partager avec vous mon expérience d’installation sur la solution DOCKER sur un NAS SYNOLOGY.

Sur la page de la documentation officielle , l’installation de home assistant sous docker est très bien expliquée, fonctionne parfaitement ( je me suis servis de cette installation au début pour tester la solution ) , mais pour accéder à la plupart des outils de la communauté où aux différents plugins , il est conseillé d’utiliser la solution HASS.IO .

HASS.IO est un système à part entière basé sur alpine linux , qui intègre la solution docker afin d’y installer la solution home assistant. Cette solution installe un module supervisor, qui est en charge de surveiller les containeurs et d’installer des plugins supplémentaires sous la forme de nouveaux containeurs, apporte aussi de nombreux outils comme la sauvegarde et un éditeur de config en ligne. Le tout de façon complètement automatisé, avec un minimum de configuration de la part de l utilisateur. Cela évite de passer trop de temps à tout réinventer.

HASS.IO est conseillé pour une installation en natif sur plusieurs type de serveur comme Rspberry PI ou encore intel NUC ( voir la liste sur le site de home ASSISTANT ) . L’installation est très simple à réaliser.

Mais revenons à mon but : installer home assistant et surtout HASS.IO sur mon synology équipé de Docker.

Encore une fois sous synology le travail a été préparé, il existe un paquet tout prêt.

Installation

- En premier lieu , installé le paquet docker , si ce n’est pas encore fait !! .

- Installation du paquet HASS.IO . Ajouter dans le gestionnaire de paquet la source des paquets de la communauté synology

2)

Paramètres / Sources de Paquet et coller l’emplacement suivant : http://packages.synocommunity.com/ , une fois configuré , je vais avoir accès à la liste des paquets de la communauté.

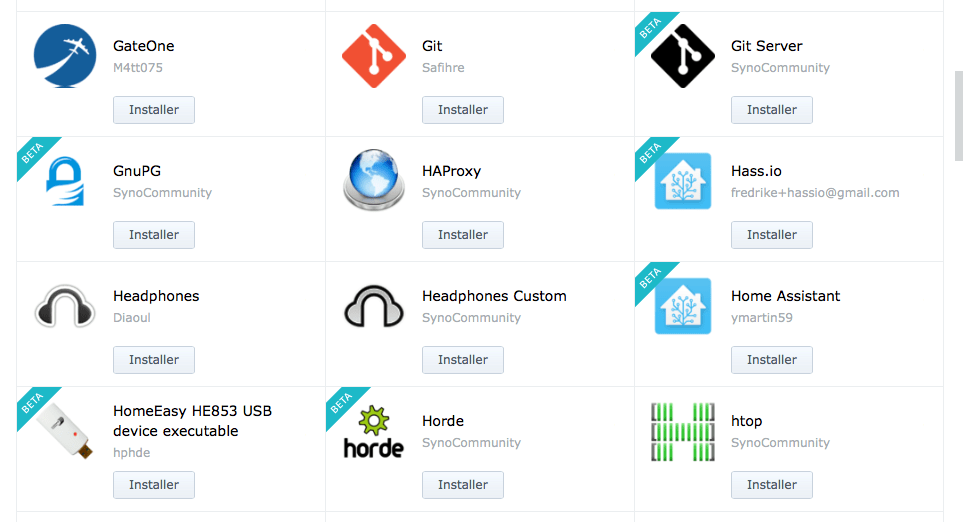

Deux paquets dédiés a home assistant sont possible , soit le paquet HASS.IO soit le paquet Home Assistant. Je m’intéresse au paquet HASS.IO de fredrike et je clic sur install. ( toute la procédure dans le fil de discussion communautaire de home assistant.

Le paquet , lance un script pour configurer Home assistant sous docker et télécharger les images de Hass.io , il va demander un espace de stockage sur votre serveur NAS , qui servira aux fichiers de configuration de home assistant.

Je choisi un nom de dossier et l’emplacement disque , pour les fichiers de configuration home assistant.

Une fois le script fini , je verifie dans mon docker que mes conteneurs hass.io sont bien activés.

Le script a lançé tous les conteneurs de la solutions hass.io , le module supervisor ( qui est le chef d’orchestre de HASS.IO ) , les conteneurs dns et multicast servent à gérer le reseau entre les differents conteneurs , le conteneur audio , gére la partie audio de home assistant et enfin le conteneur home assistant . Il ne me reste plus qu’a me connecter a l’adresse suivante : http://ipNAS:8123

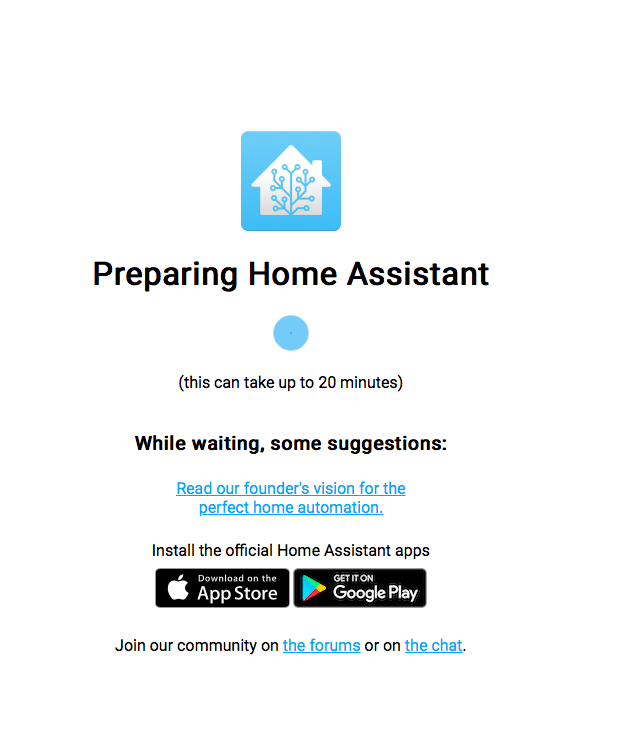

Le premier démarrage , m’invite à patienter environ 20 minutes .En effet lors de l’installation , le script télécharge la dernière image à jour de Home assistant.

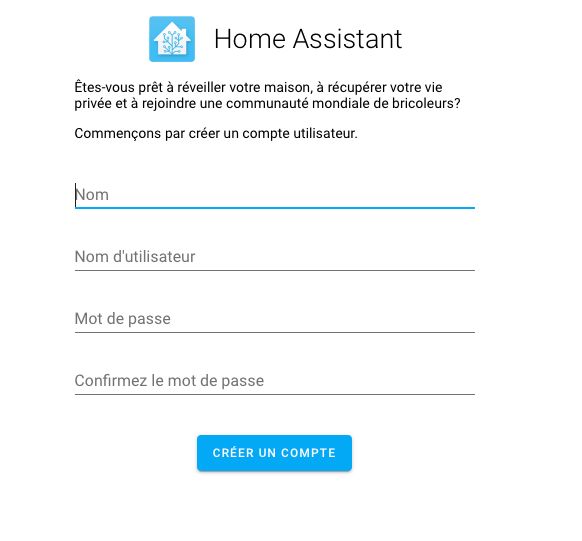

Après plusieurs minutes , un bon café , une petite pause …. La page d’accueille s’affiche , m’invitant à créer mon premier compte.

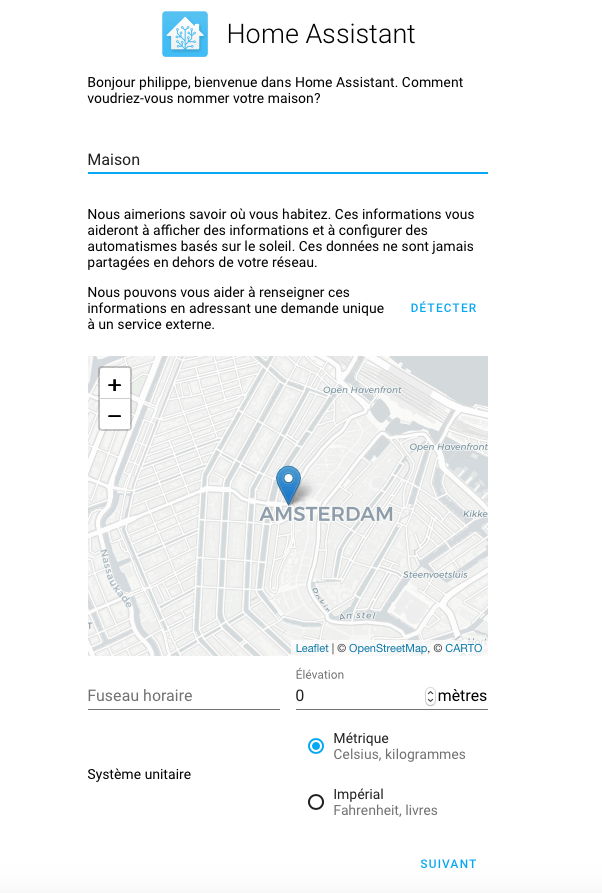

Puis , il est possible d’indiquer la localisation de sa maison , afin de bénéficier automatiquement des services météo et localisation.

Les premières intégrations

Home Assistant , me propose d’intégrer automatiquement , tous les appareils trouvé sur mon réseau , comme mon pont HUE , mes SONOS , mon routeur etc …..

Une fois le pont HUE connecté à Home Assistant , il me propose de récupérer tous les périphériques attachés à ce pont. ( lumières , dimmer , tap , capteurs etc … )

Il a détecter, aussi , mes sonos et mes synology.

Tout de suite , je peux constater la facilité d’intégrer ce type de module. Je verrais par la suite pour les autres équipement.

Pour intégrer mes modules RFXcom et Zwave ( via la clé usb GEN 5 ) , home assistant ne semble pas les reconnaitre ? La solution , au chapitre suivant.

Le supervisor de HASS.IO

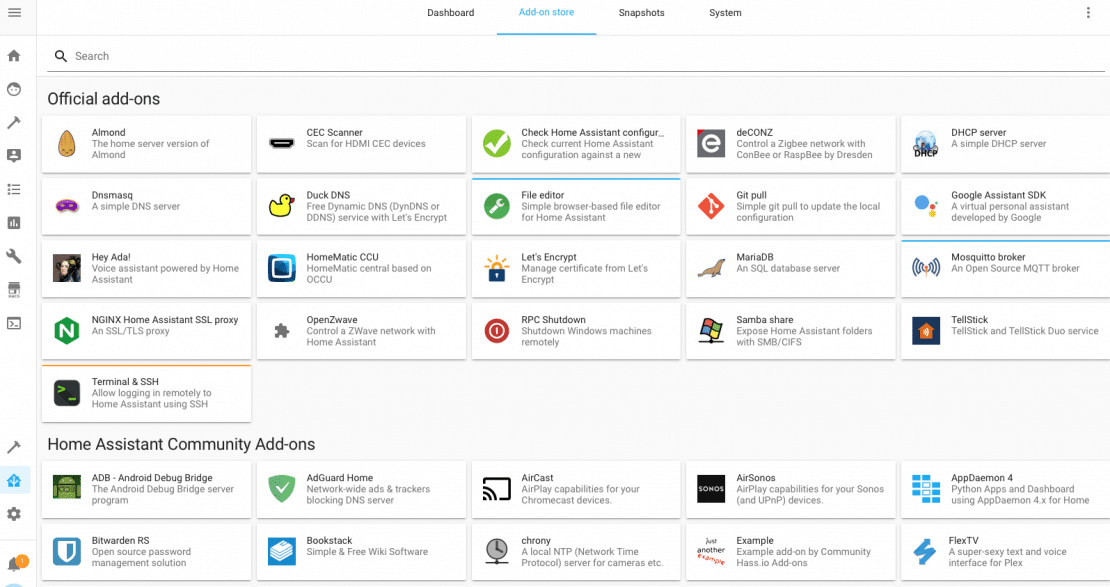

Comme expliqué en début , l’intérêt d’installer HASS.IO et d’avoir accès au module SUPERVISOR et à tous ses plugins.

Il suffit pour cela de cliquer sur supervisor ( juste au dessus de configuration ) pour afficher la page des plugins installés / plugin disponible / Snapshot / info système

Le premier plugin à installer et File editor , qui permet d’éditer les fichiers de configuration de HA , directement depuis l’interface WEB. Ce plugin , sert à éditer les fichiers , mais permet aussi de vérifier la syntax , ainsi qu’un accès à toutes les entités et appareils de Home office ( vous comprendrez plus tard ).Il devient vite indispensable.

Si vous avez installé , HASS.IO sur un autre système que le NAS synology , le plugin samba share , vous permettra d’accéder à vos fichiers de configuration. Ici , sur une installation NAS + Docker , je me sers du partage fourni par synology. C’est le dossier qui a été demandé lors de l’installation du paquet.

Si vous avez besoin d’un Broker MQTT , je vous conseille d’installer le broker fournis avec supervisor ( Mosquito ) qui permet une intégration sécurisé avec Home Assistant. La configuration par défaut fonctionne bien. Il faudra s’identifier sur le Broker , avec un compte Home Assistant.

Pour les autres plugins , je vous laisse voir selon vos besoins.

Attention , a ne pas installer de plugin qui pourrait entrer en conflit avec un Port réseau de votre serveur NAS ( Par exemple SSH , qui est par défaut sur 22 ) .

Mon synology , ne voit pas mes clés USB Zwave ou RFXCOM ?

Le script à été conçu pour remonter automatiquement les clés USB , dans Home assistant , mais voilà certaines ne sont pas reconnu . Cela vient du Synology , qui ne posséde pas tous les drivers. Il va falloir ajouter un package , qui s’occupe de ça : USB serialdriver de jadahl.

Pour cela , je récupère le package correspondant à mon NAS : Clic sur DSM 6.2 drivers / puis je sélectionne mon NAS.

Dans le gestionnaire de paquet synology , je sélectionne installation manuelle . Je redémarre mes images HASS.IO , pour prendre en compte les changements , via l’interface docker.

Je peux verifier , dans la page de configuration de home assistant .

Menu supervisor /System / Hardware

il ne me reste plus qu’a réintégrer mes capteurs zwave et RFXcom. Pour la partie zwave et rfxcom , et d’autres protocoles , je reviendrait au fur et à mesure de mon avancement dans la solution home assistant.

Si vous voulez franchir le cap , il ne vous reste plus qu’a essayer.Je vous invite à lire la documentation officielle , ainsi que les différents blogs sur home assistant , afin de vous faire votre propre avis.

En conclusion

Il n’est pas facile de passer d’un système domotique à un autre. Quel que soit le choix du système, cela prendra beaucoup de temps. Et je ne vous cache pas que si demain vous décidez de migrer , prévoyez du temps.

Cela fait maintenant une dizaine de jours que mon serveur Home Assistant à remplacé mon Jeedom , je n’ai pas encore eu le temps de tout réintégrer , ni de reconstruire tous les scénarios. Mais le plus gros est fait ,

- Pilotage de mes volets Somfy par RFXCOM : OK

- Lecture des sondes de température par RFXCOM : OK

- HUE : Tout est ok , lumières , capteurs et interrupteur

- Sonos : ok pris en charge complète ( avec TTS )

- Tracker , localisation , gestion des personnes : OK

- Scénario ouverture et fermeture auto : ok ( Pour les scenarii plus complexe , je n’ai pas encore eu le temps de me pencher sur le langage interne utilisé )

- notification : ok

- notifHeure : ok

Pour la partie Zwave , tous mes modules ont été reconnu : Fibaro , Qubino , Nodon , Aeon , Aeotec , strip sensative etc … , tous reconnu ( 84 au total ) , mais cela à demandé beaucoup de temps . Une fois ma clé USB , connecté à home assistant , celui ci à installé automatiquement les bibliothèques Zwaves adéquates , et environ 70 modules ont tout de suite été reconnu. Les plus récalcitrant sont ceux sur piles , mais pas toujours les mêmes .

- 3 capteurs multifonctions FIbaro ( Oeil ) FGMS-001 : j’ai du les supprimer du réseau et les re inclure.

- 2 capteurs d’ouvertures Fibaro ( FGK-101 ) : idem , supprimer et ré inclure.

- Les deux switchs Nodon ( octan remote ) : idem

- Un capteur d’ouverture : Aeotec ( door /windows 6 )

- 3 vannes danfoss : idem , besoin de réinclure.

Pour chaque modification zwave , sous home assistant , il est conseillé de redémarrer le serveur home assistant , afin que les modifications soient bien pris en compte.

L’application mobile est un plaisir à utiliser , aucun ralentissement et accès à toutes les fonctionnalité. Ma femme à tout de suite pris en main la nouvelle application mobile et la trouve plus simple à utiliser au quotidien que l’ancienne.

Après ces quinze jours , avec home assistant , je ne vois pour l’instant que du positif. Et je n’ai découvert encore que très peu de fonctions. Ce qui me laisse entrevoir encore beaucoup de possibilité.

Il faut penser , à réaliser des snapshots réguliers , car il peut être très facile de faire une fausse manoeuvre sur un des fichiers de configuration. Pour se retrouver avec un systéme qui ne démarre plus. Mais heuresement la restauration est trés rapide.

6 mois plus tard …

Après 6 mois d’utilisation sous docker , mon systéme home assistant est toujours opérationnel et supporte très bien toutes les mises à jours.

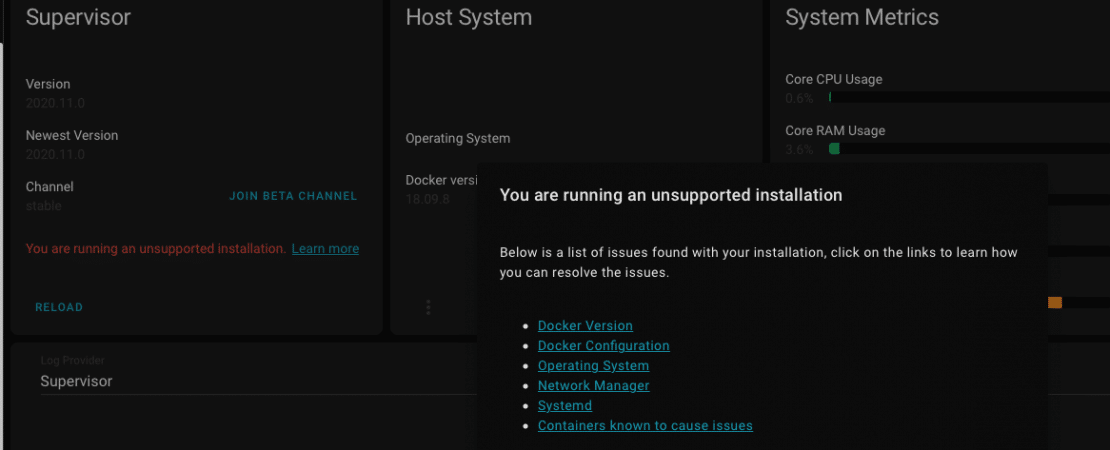

Malgré le message d’avertissement du supervisor , indiquant que ce système n’est pas pris en charge, tout est ok

Astuces …

Modification 05/12/2020

Depuis la version 2020.11.2 du supervisor , une option à été activé pour interdire les mises à jours des addons sur un systéme “unhealthy” , en cause la version de docker sur synology qui est en 18.

Dans l’attente, que synology docker passe à la version 19 , il existe un moyen de forcer ce comportement.

Tout est expliqué dans ce fil de discussion

supervisor issue

La solution consiste à créé un fichier jobs.json à la racine du dossier hass.io et de renseigner la clé suivante : {“ignore_conditions”: [“healthy”]}

Puis il faut redémarrer le conteneur supervisor.

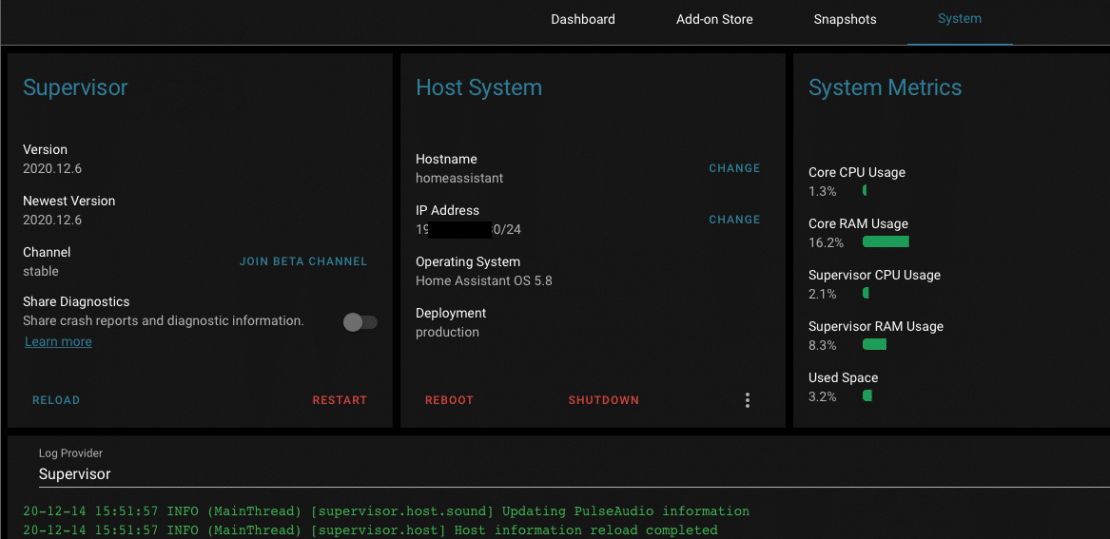

Virtual Machine Manager

Il est possible d’installer hass.io sous virtual manager du synology , je l’ai testé , tout fonctionne bien et pas de message d’erreur de version non supporté.

Les clés suivantes sont très bien reconnues : USB Zwave Gen5 , USB rfxcom , USB bluetooth , USB vers onduleur et USB vers Zigbee.

Mais il y a des contraintes :

- Une limitation à 4 USB max

- Un serveur Synology compatible avec Virtual Manager et au moins 4 go de Ram , pour un fonctionnement sans trop de ralentissement.

Plus de détails dans la seconde partie de l’article.

30 commentaires sur “Un Serveur domotique Home Assistant ( HASS.IO ) sous Synology – Partie 1”

Bonjour,

Après quelques semaines de prise en main, mon installation de Home Assistant via hass.io me donne beaucoup de satisfaction. Cela m’a même permis d’utiliser mes appareils non certifiés HomeKit sur mon iPhone.

Maintenant, je viens de faire un tour vers le Superviseur… Et là, un petit problème :

– Une mise à jour de Home Assistant m’est annoncé. Quand je clique sur « Update », une petite roue tourne tant que je n’ai pas confirmé ; mais quand je le fais, rien ne se passe.

– idem pour les addons : ils sont visibles, mais quand j »en choisis un et que je clique su « install », j’ai le message « Failed to install addon – Unknown error, see supervisor ».

Qu’est-ce qui peut bien clocher ?

Bonjour alain ,

En effet , depuis la version 2020.11.2 du supervisor , une option à été activé pour interdire les mises à jours des addons sur un systéme « unhealthy » , en cause la version de docker sur synology qui est en 18.

Dans l’attente de passer a la version 19 , peut etre que la mise a jour de DSM 7 prevu sur 2021 apportera cette mise a jour , il existe un moyen de forcer ce comportement.

Tout est expliqué dans ce fil de discussion

supervisor issue

La solution consiste à créé un fichier jobs.json à la racine du dossier hass.io et de rensigner la clé suivante : {« ignore_conditions »: [« healthy »]}

Puis il faut redémarrer le conteneur supervisor.

Et si pas de soucis , cela devrait fonctionner à nouveau. Chez moi ça fonctionne avec cette manip.

Bonjour et merci du conseil. J’ai créé et mis en place le fichier jobs.json.

Hélas, dans mon cas, cela n’a rien changé, malgré toutes sortes de redémarrages et de réinitialisations.

J’ai aussi visité le lien et j’ai vu que cela n’avait pas fonctionné pour tous, mais au moins, c’est bien pour les autres

Bonjour,

J’ai installé home assistant sur raspberry 3 b afin d’utiliser le protocole enocean avec la clé usb TCM310, seulement voila si la clé reçoit bien les capteurs, impossible de comprendre comment procéder. J’ai bien install l’intégration enocean, activé mais comment faire ensuite. Par avance merci de l’aide que vous pourrez m’apporter.

Bonjour thierry,

je vais tenter de vous répondre , en faisant l’analogie avec zigbee , zwave ou rfxcom , je n’ai pas de clé enocean pour l’instant . Mais pour ces autres protocoles , dans home assistant la configuration se passe au niveau de la page d’intégration , sur l’intégration concerné vous avez accès soit a un menu configurez ou un menu option.

Ce menu apparait si la clé est bien reconnu et que l’intégration à bien fonctionné.

Dans l’ordre , il faut verifier si la clé USB est bien remonté dans le supervisor. Menu systeme / host system et sur les trois petit point ( hardware ) , qui affiche tous les ports usb reconnu par hass.io.

Si la clé ne remonte pas , il peut y avoir un problème de driver non pris en charge par le raspberry.

Si la clé est bien reconnu , suivre l’intégration de home assistant : enocean home assistant

Pour le nom du port usb de la clé , preferez les noms définit en serial-by-id : exemple /dev/serial/by-id/usb-Silicon_Labs_HubZ_Smart_Home_Controller_C0F003D3-if01-port0 pour du zigbee

a la place de /dev/ttyUSB0 .

Bonjour,

Merci, ce tuto est très clair.

Mon problème est que tout semble tourner, mais que je ne parviens pas à accéder au port 8123, ni avec l’IP locale ou externe, ni avec Quickconnect.to, ni avec xxx. synology .me

bonjour alain ,

La première chose à vérifier et l’accès local , pour l’accès extérieur , il faudra mettre en place un système de routage via votre routeur.

Si pas d’accès en local , je ne vois que deux raisons .

Le premier , versifier si le parefeu du NAS , n’est pas activé ? Panneau de configuration , sécurité , pare-feu . Si activé , le désactiver pour tester , puis si fonctionne créé une régle pour laisser passer le port 8123.

Deuxième point a vérifier , si c’est bien le port 8123 , qui est activé sur le service hass.io

Panneau de configuration , centre infos , service , et verifier dans la liste des services si le port local pour hass.io est bien réglé sur 8123.

Bonsoir et merci de cette prompte réponse.

Malheureusement, pare-feu désactivé et vérification du port effectuée, je me fais toujours refuser l’accès en local 192.168.1.49:8123 (Nota : j’ai vérifié que 192.168.1.49:5000 me conduisait à l’interface de gestion du NAS.

Bonsoir,

Apparemment, tous les modules de hass.io n’étaient pas chargés.

J’ai donc tout remis à zéro et relancé la procédure d’installation.

Cette fois, pas de problème

Désolé pour cette intervention et merci encore pour l’aide

Super

Bonjour,

Perso j’ai le même pb que Alain.

Et j’ai essayé de refaire la manip mais rien, c’est assez étrange je n’ai que supervisor dans conteneur/docker qui se met …

Adrien

Peut être un soucis avec les dernières versions du Hass.io.

Ou voir avec alain , il a du recommencer l’installation a plusieurs reprises , les conteneurs ne se téléchargés pas tous.

Pour info , le conteneur home assistant est assez long à chargé la première fois ( surtout si il y a eu des mises a jours récentes ) , il faut compter environ une trentaine de minutes , avant de le voir apparaitre.

Bonjour,

de mon coté j’ai pu résoudre mon problème, où je n’avais que le module supevisor qui s’installait, en désactivant le parefeu de mon NAS … et boummmmm ça fonctionne ^^

Bonne journée

Adrien

Bonjour,

Vous n’avez pas eu de dommages collatéraux sur les autres packages ?

J’ai en tête le vpn qui ne marche plus depuis l’installation de hass.io

Le problème est d’ailleurs décrit sur leur forum, mais pas la solution. Je viens de demander de l’aide chez eux.

Bonjour ,

Pas de soucis de compatibilité pour l’instant avec les paquets que j’utilise ( je n’utilise pas le VPN , sur mon syno )

Les principaux paquets installés sont : Surveillance station , plex , ffmepg , video station , multimedia , virtual manager , momments et dsphoto , synology office , python , php , sql , etc ….

Paquet Docker : j’ai hass.io , maria db , tautulli , watchtower , pottainer ,phpmyadmin etc …

Sous hass.io , j’ai activé les addons mosquito , appdaemon , dashio , esphome ,nodered , ssh et d’autres.

Je n’ai pas activé adguardhome , qui provoque des erreurs de transfert DNS , et m’oblige à remodifier tous les ports sur le syno. Je préfère passer par un RPI avec PI-hole dans un coin du réseau.

J’utilise un certificat lets encrypt sur mon syno , et avec les régles de proxy inversé du syno me permet de bénéficier du chiffrage SSL pour les accès extérieurs.Le certificat est renouvelé automatiquement par le syno.

Vérifie aussi sur ton reseau, le server upnp du nas n’es plus visible (j’ai un DAC réseau).

Je vais peut être m’orienter vers une solution Hass OS avec VM.

Pas de soucis avec upnp , je peux parcourir avec mes differents lecteurs. Maintenant , je me souviens avoir eu un problème de serveur UPNP qui avait disparu à la suite de l’installation de docker ainsi que la mise en place de l’agrégation des deux cartes réseaux. La configuration de la sortie réseau pour le serveur multimedia avait sauté. Il suffit d’aller dans l’application serveur multimedia et choisir la bonne interface réseau dans configuration générale.

Peut être que que ça a marché avec le serveur upnp, je n’ai pas essayé sur le coup.

Mais sur le server VPN, impossible de sélectionner quoi que ce soit, la case reste vide sans pouvoir laisser le choix à l’utilisateur.

Je ne sais pas où se trouve le fichier de config, je ne sais pas si la solution est pérenne après mise à jour ou reboot par exemple.

Chez moi , hass.io tourne depuis plus de 8 mois sous docker , toutes les mises a jours se sont bien passés. Mon syno a eu aussi des mises a jours et des reboot. Pour l’instant tout est ok.

Bonjour .

Je test aussi la solution suite à des soucis avec jmqtt sur nextdom.

Et franchement je trouve le solution top.

Aurais tu déjà envisagé pour les volets Somfy de contrôler un %. J’aimerais bien envisager ça aussi… J’ai le même matos, rfxcom et Somfy…

Bonjour jonathan,

en effet , je découvre des nouvelles choses , chaque jour et je dois dire que je me régale . Trés facile d’avoir des vues personnalisées , une multitude de config en ligne , qui permet de voir tout le potentiel !!

Pas tester encore le % , cela doit etre possible avec un compteur temps . Mais déréglé des que l’on appuie sur les commandes manuels.Par contre l’intégration des volets est vraiment top , et super facile de faire des groupes de volets.

Oui il faudrait que je me penche dessus .Je n’ai pas encore fait de groupe mais c’est une.bonne idée .je vais mettre ça en pratique des demain

Bonjour pouvez-vous décrire la procédure pour créer des groupes de volets? Avec la commande du groupe qui pilote tous le volets du groupe car moi pour le moment ça me fait des groupes de volets que je dois activer un par un..

Merci

bonjour pascal ,

il est très facile de regrouper des volets dans HA.

Exemple dans le menu configuration.yaml

Il faut utiliser le mot clef cover

exemple déclaration des groupes COVER.

# exemple dans configuration.yaml

cover:

– platform: group

name: volets parents

entities:

– cover.volet_parents_petit

– cover.volet_parents_grand

– platform: group

name: volets salon

entities:

– cover.volet_salon_1

– cover.volet_salon_2

– cover.volet_salon_3

On obtient alors deux nouvelles entités volets ( cover ) : cover.volets_parents et cover.volets_salon

Il est possible aussi de grouper des groupes

un exemple de mon fichier

## groupe tous les volets sauf volets porte jardin

– platform: group

name: tous les volets

entities:

– cover.pieces_de_vie

– cover.volet_cuisine

– cover.volets.salon

– cover.volets_parents

Lien dédié à cette explication : https://www.home-assistant.io/integrations/cover.group/

Personnellement, je n’ai pas touché au fichier .yaml et je me suis servi des scripts, scènes et automations que l’on trouve sous la rubrique « Configuration ». J’ai créé un script ouvrir_volets et un autre fermer_volets que j’utilise soit directement via alexa, soit par deux automations pour les fermer x minutes après le coucher du soleil et les ouvrir à 8h30 le matin.

ça me titille depuis longtemps aussi de switcher vers HA j’ai aussi installé un docker sur mon NUC pour découvrir l’écosystème que j’ai trouvé un peu fouillis, j’ai intégré quelques modules, mais je n’ai pas accroché mais HA évolue si vite que cela a du changer et je supporte de moins en moins jeedom (et surtout sa communauté) les choix pas toujours compréhensibles.

bon il vas vraiment falloir que je m’y mette sérieusement.

Effectivement je me sentais un peu à l étroit sous jeedom.

Avec HA je redécouvre la domotique.

Il y a tellement de possibilité….

Surtout couplé a node red pour les automations .

PAs encore eu le temps de regarder du coté de node red , mais à l’occasion je jetterai un coup d’oeil.

🙂

Perso je trouve ça super sympa .. ha est super réactif et tout est gratuit